视觉BEV基本原理和方案解析

视觉BEV基本原理和方案解析

以下为文章全文:(本站微信公共账号:cartech8)

汽车零部件采购、销售通信录 填写你的培训需求,我们帮你找 招募汽车专业培训老师

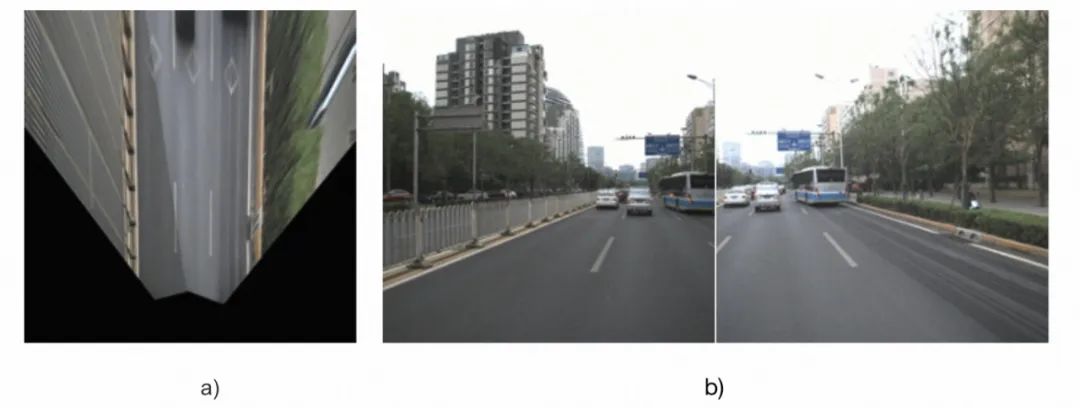

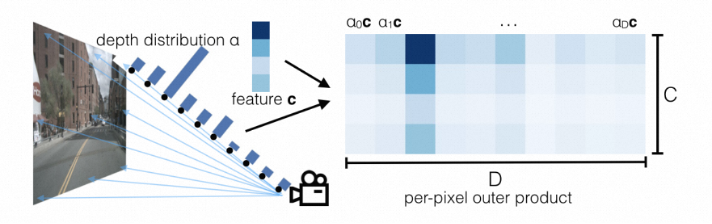

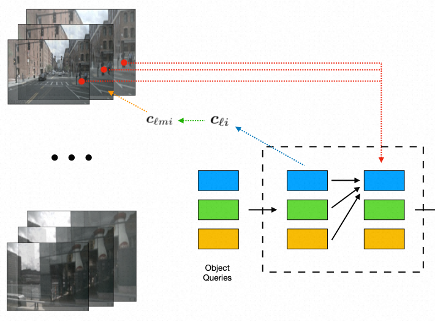

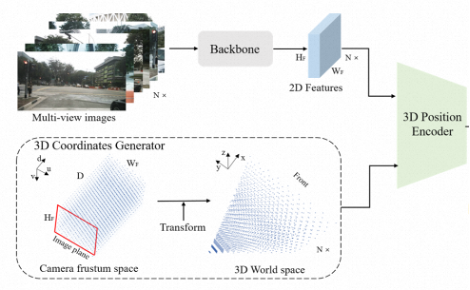

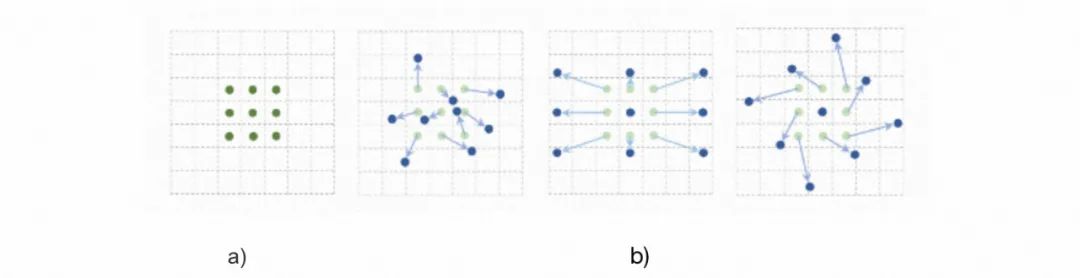

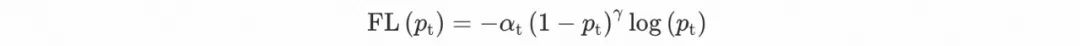

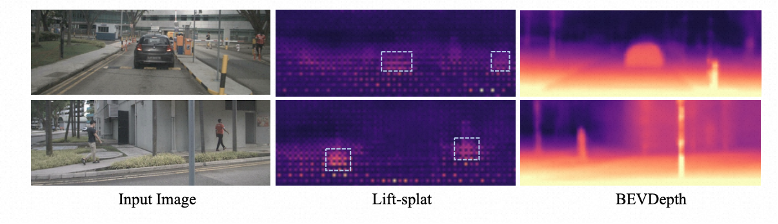

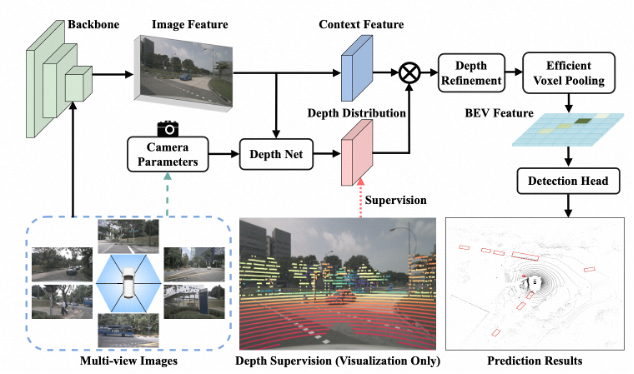

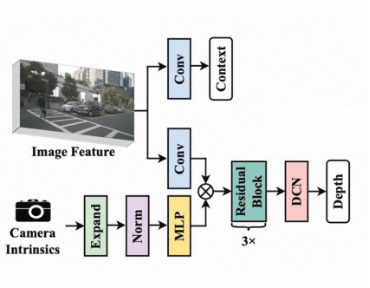

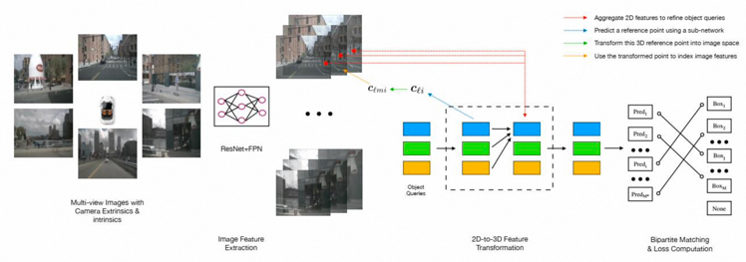

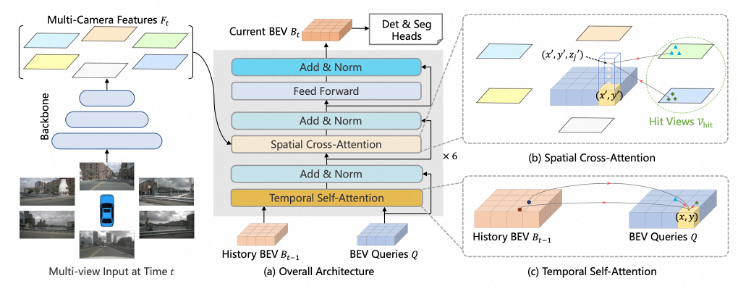

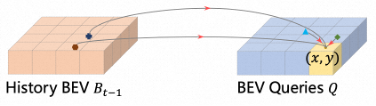

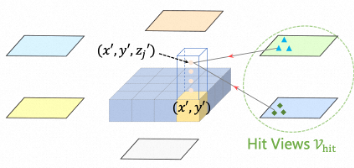

EV(Bird’s-Eye-View)是一种鸟瞰视图的传感器数据表示方法,它的相关技术在自动驾驶领域已经成了“标配”,纷纷在新能源汽车、芯片设计等行业相继量产落地。BEV同样在高德多个业务场景使用,例如:高精地图地面要素识别、车道线拓扑构建、车端融合定位中都扮演了重要角色。如图1?1所示: 图1?1 BEV在高德应用场景(仅列举部分)a)高精底图 b)地面要素识别 c)车道线拓扑构建[1] d)车端融合定位(BEV特征和底图匹配)[2] 本文分享的内容主要包括两个部分:视觉BEV基本原理、方案解析。 1.BEV基础 1.1.引言 如图1?2所示,BEV具有如下优势: 1) BEV视图尺度变化小。在PV空间(即透视图,类似通常行车记录仪所采集的车辆前视图)中,物体近大远小,物体的大小和类别、远近都有关,而在BEV空间中,物体的大小只和类别有关; 2) BEV空间是决策友好空间。BEV空间更接近3D真实空间的平面空间,而PV空间是真实物理世界在透视投影下的视图,以图1?2的车道线举例,在真实世界中平行的两条车道线,在BEV空间下还是平行的,在PV空间却是相交的。相比之下,BEV空间下的信息能更方便地被下游规控模块理解和使用。 本章将介绍BEV基础知识。首先介绍BEV的核心“视角转换模块”的基本原理,包括2D->3D和3D->2D两种路线,然后介绍BEV使用的魔法“可形变模块”,最后介绍BEV方案中常用的损失函数。  图1?2 BEV空间和PV空间的图像可视化a) BEV空间 b) PV空间 1.2.视角转换 如1.1所述,在BEV空间下进行数据处理和操作具有尺度变化小、决策友好的优势,但原始的图像数据是在PV空间下的,如何将PV空间的数据转换到BEV空间或者是3D空间(有3D空间下的数据,将其拍扁就能转到BEV空间)呢?这就是视角转换模块要干的事。 1.2.1. 2D->3D转换模块 2D->3D转换模块基本思想是从2D像素或者特征出发去找3D空间下的对应表示,类似深度估计。下面介绍主流的2D->3D转换方法。 LSS(Lift-Splat-and-Shot)[3]是主流的2D->3D转换方法,如图1?3所示,Lift指对各相机的图像显式地估计特征点的深度分布,得到包含图像特征的视锥(点云);Splat——结合相机内外参把所有相机的视锥(点云)分配到BEV空间的网格中,对每个格子中的多个视锥点进行pooling计算,形成BEV特征图;Shoot——用task head处理BEV特征图,输出感知结果。最后将C维的特征和D维的深度分布做外积,得到每个深度下的特征,深度概率越大,对应特征响应就越强。  图1?3 LSS示意每个特征点生成系列离散深度点,再为深度点生成特征[3] Pseudo-LiDAR是另一种2D->3D转换方法,如图1?4所示,相比LSS为特征点预测一系列离散深度,Pseudo-LiDAR直接预测深度图,每个像素都有且仅有一个深度。  图1?4 Pseudo-LiDAR示意预测深度图,根据原始图像和深度图映射至3D空间[4] 1.2.2. 3D->2D转换模块 3D->2D转换模块基本思想是根据3D点查找对应的2D特征,类似3D空间投影到PV空间。下面介绍主流的3D->2D转换方法。 如图1?5所示,将3D参考点根据成像原理投影到PV空间获取对应图像特征的方式可以认为是显式映射,这里的参考点可以使用预设的BEV空间的参考点,也可以使用网络生成。  图1?5 显式映射[5] 相比显式映射,隐式映射不再通过投影映射,而是让网络自己学特征和3D坐标的映射。如图1?6所示,它先生成视锥空间下的一系列点,再转换到3D空间下,然后将提取的图像特征和3D点传入encoder,encoder处理后输出的就是带有3D坐标信息的特征。  图1?6 隐式映射[6] 1.3. 可形变模块 要介绍的可形变模块有两种,可形变卷积和可形变注意力,可形变模块的作用更容易通过可形变卷积理解,所以先介绍可形变卷积。 可形变卷积是在卷积的基础上添加offset得到的,如图1?7最左边的a) 所示,普通卷积通过人工设计的pattern整合pattern内采样点的信息,其pattern设计好后就是固定的,可形变卷积,如图1?7 b) 所示,可以计算出每个采样点的offset,采样点+offset才是真实的采样点,使得卷积的pattern形式更加灵活,且一定程度上可学习。  图1?7 可形变卷积示意a) 普通卷积 b) 可形变卷积[7] 如图1?8所示,注意力机制需要通过Q (query) 找到K (key),获得K的信息,这个过程也存在可变形的操作空间,让网络自己学习参考点的偏移量。  图1?8 可变形注意力示意[8] 1.4. 损失函数 损失函数大部分与任务相关,且大同小异,这里集中介绍下后续方案解析需要用到的一些共性的损失函数。 Box Loss (包围盒损失函数) 是目标检测常用的几何损失函数,常采用L1 Loss的形式:  Focal Loss是交叉熵损失函数的拓展,常用于分类问题。普通交叉熵损失函数在正负样本不均衡时表现不佳,因此引入平衡交叉熵。另外普通交叉熵损失函数对于难例无法重点学习,因此引入难例聚焦。最终形式为:  2. 视觉BEV方案解析 2.1. 引言 第一章的内容为第二章的方案解析打下知识基础,接下来第二章主要解析具有代表性的视觉BEV方案,主要根据视角转换模块的类型对方案进行分类,首先介绍2D->3D的代表性方案,然后介绍3D->2D的代表性方案。 2.2. 2D->3D代表性方案解析 2D->3D的代表性BEV方案有BEVDet和BEVDepth,下面我们逐一介绍。 2.2.1. BEVDet 3D目标检测跟踪由基于PV空间的方法主导,BEV语义分割跟踪由基于BEV空间的方法主导,那么PV空间和BEV空间哪个更适合做自动驾驶感知呢?是否可以在同一的框架下做这些任务?作者为了回答这两个问题,提出了如图2?1所示的基于BEV空间的3D目标检测框架,BEVDet。BEVDet主要由四个部分组成,分别为图像特征编码器,视角转换模块,BEV特征编码器,检测头。  图2?1 BEVDet框架[9] 图像特征编码器(Image-view Encoder)使用2D Backbone网络,如ResNet、SwinTransformer等,对输入的多视角图像做多尺度特征提取,得到多尺度特征。 视角转换模块(View Transformer)对输入的多视角图像特征使用LSS进行离散深度分布预测,获得3D视锥特征。 3D视锥特征经过pooling操作拍扁到BEV空间,BEV特征编码器(BEV Encoder)对BEV空间下的特征做多尺度特征提取,得到BEV特征。 最后送入检测头进行3D目标检测,分类监督使用的损失函数为Focal loss,包围盒监督使用的损失函数为L1 loss。 2.2.2. BEVDepth 作者实验发现LSS估计的深度替换成随机值影响不大,而采用真值深度对指标提升很大,因此得出LSS估计深度不准的结论,如图2?2所示,在没有明确的深度监督的情况下,很难输出准确,泛化性强的深度感知结果,要想获得更好的检测结果,需要更准的深度,因此引入深度监督训练深度子网络。  图2?2 LSS的深度预测结果和BEVDepth的深度预测结果的对比[10]图2?3是BEVDepth的框架,也能大致分为图像特征编码器,视角转换模块,BEV特征编码器,检测头四个部分。图像特征编码模块大同小异,后续不再展开说明。  图2?3 BEVDepth框架[10] 视角转换模块的核心是深度估计,深度估计网络DepthNet的框架如图2?4所示,首先使用MLP对相机内参进行特征化,然后用SE (Squeeze-and-Extraction) 对图像特征进行通道加权,然后经过3个残差块以及可形变卷积,得到深度。深度再与图像特征进行外积,得到3D视锥特征。  图2?4 深度估计网络框架[10] 相机和用于监督的点云之间的外参可能不准,内参也可能不准,都会导致深度估计有偏,因此BEV特征编码器引入深度修正对3D视锥特征的深度进行修正,然后进行高效体素池化获得BEV特征。 检测头所使用的损失函数和BEVDet是一致的,不做赘述。深度监督使用的损失函数为二分类交叉熵。 2.3. 3D->2D代表性方案解析 前面介绍的2D->3D的方案始终绕不过深度估计,深度估计难免会引入误差,换个思路,先有3D点,再根据3D点找2D特征的方式无需进行深度估计,避免了这部分误差。3D->2D的代表性方案有Detr3D、BEVFormer和PETR。 2.3.1. Detr3D 如图2?5所示,Detr3D是Detr在3D目标检测的扩展,也是使用query进行特征获取,然后进行检测。Detr3D的图像特征编码器大同小异,不再赘述。  图2?5 Detr3D框架[5] 特征转换模块首先使用object query生成3D参考点,将参考点投影到PV空间获取图像特征,获取到的图像特征能进一步优化物体的3D表征,得到物体的3D特征。 将特征送入检测头进行目标检测,可以得到一系列的检测结果。普遍地,大家会用NMS等后处理方式获得最终用于Loss计算的检测结果,如图2?6所示,Detr3D继承了Detr的做法,采用双边图匹配获得与真值一一对应的检测结果。损失函数与前面所述并未本质差异,不做赘述了。  图2?6 双边图匹配获得与真值一一对应的检测结果[11] 2.3.2. BEVFormer 行车过程有天然的时序特点,当前帧看到的车道线,在后续几帧大概率也是存在且可见的,如何利用这个时序特点是前述方案没有考虑的。BEVFormer引入时序信息进一步增强BEV的检测能力。BEVFormer的图像特征编码模块和前述大同小异,不做赘述。 BEVFormer的核心是中间的BEV特征编码模块,BEV特征编码模块的核心是时序自注意力(Temporal Self-Attention)和空间交叉注意力(Spatial Cross-Attention),时序注意力是为了利用历史帧BEV特征增强当前帧BEV特征,空间交叉注意力则是为了从图像特征获取信息。  图2?7 BEVFormer框架[12] 具体地,BEVFormer的时序自注意力首先利用车辆运动信息将当前帧BEV特征和历史帧BEV特征进行对齐,然后再使用自注意力融合两者信息,由于车辆运动信息可能不准,不同时刻周围的可利用信息分布也不一致,所以具体使用的是图2?8所示的可变形注意力机制。  图2?8 时序可变形自注意力[12] BEVFormer的空间交叉注意力首先为每个格子在Z方向上采样4个值,得到一个格子上的4个参考点,然后与图像特征进行交叉注意力,获得图像特征。如图2?9所示,这里的交叉注意力也采用可变形注意力机制。  图2?9 空间可变形交叉注意力[12] 损失函数的计算和Detr3D一致,不再赘述。 2.3.3. PETR 3D->2D的方案一般都需要将参考点投影到PV空间,再取图像特征,PETR避免了复杂的3D->2D转换及特征采样,直接让网络自己学习2D-3D的映射。PETR的框架如图2?10所示,包括图像特征编码器、3D坐标生成器、3D特征编码器(3D Position Encoder)、3D特征解码器和检测头。图像特征编码器大同小异,不再赘述。  图2?10 PETR框架[6] 3D坐标生成器生成视锥空间的一系列3D点,具体地,首先将相机视锥空间离散成大小为的网格,网格中的每一点用表示。3D空间中一个点用表示。通过相机内外参可以将相机视锥空间转换到3D空间中。最后再进行归一化。 2D图像特征和3D坐标一起送入到3D特征编码器中,2D特征进行卷积通道降维,3D坐标进行位置编码,然后将处理后的2D特征和3D坐标编码整合,最后特征展平。  图2?11 3D特征编码器[6] 3D特征解码器先在3D空间生成一系列随机点,再通过MLP生成可学习的query,query在3D特征中取特征,最后使用检测头进行检测。损失函数与Detr3D大同小异,不再赘述。 3. 总结展望本文从BEV的基础出发,介绍了视觉BEV具有代表性的方案。视觉BEV已经展现出强大的场景理解能力。但是还存在很多值得探索且有挑战的方向[13]: 深度估计是BEV的核心,LSS、Pseudo-LiDAR、激光蒸馏、立体视觉或运动恢复结构等都是有前景的方向。 如何融合传感器的信息也是至关重要的,使用Transformer的自注意力、交叉注意力融合不同模态的特征已经被证明是个可行的方向。多模态中CLIP的文本-图像对也是个很有启发的思路。 泛化性是深度学习亘古不变的话题和努力的方向,在一个设备(数据)上训练好的模型在另一个设备(数据)表现是否一样好。每个设备都要付出训练成本是让人难以接受的。如何将模型和设备解耦在未来一段时间都将是重要的研究方向。 大模型或者基础模型已经在不同领域上取得令人印象深刻的结果,并一举成为SOTA。在BEV感知中如何利用大模型中丰富的知识,在更多的任务上取得更好的效果,这将会逐步引起人们的重视。 参考文献[1] Bencheng Liao, Shaoyu Chen, Xinggang Wang, et al. Maptr: Structured modeling and learning for online vectorized hd map construction[J]. arXiv preprint arXiv:2208.14437,2022,[2] Yuzhe He, Shuang Liang, Xiaofei Rui, et al. EgoVM: Achieving Precise Ego-Localization using Lightweight Vectorized Maps[J]. arXiv preprint arXiv:2307.08991,2023,[3] Jonah Philion and Sanja Fidler. Lift, splat, shoot: Encoding images from arbitrary camera rigs by implicitly unprojecting to 3d[A]. Springer: 194-210[4] Yan Wang, Wei-Lun Chao, Divyansh Garg, et al. Pseudo-lidar from visual depth estimation: Bridging the gap in 3d object detection for autonomous driving[A]. 8445-8453[5] Yue Wang, Vitor Campagnolo Guizilini, Tianyuan Zhang, et al. Detr3d: 3d object detection from multi-view images via 3d-to-2d queries[A]. PMLR: 180-191[6] Yingfei Liu, Tiancai Wang, Xiangyu Zhang, et al. Petr: Position embedding transformation for multi-view 3d object detection[A]. Springer: 531-548[7] Jifeng Dai, Haozhi Qi, Yuwen Xiong, et al. Deformable convolutional networks[A]. 764-773[8] Xizhou Zhu, Weijie Su, Lewei Lu, et al. Deformable detr: Deformable transformers for end-to-end object detection[J]. arXiv preprint arXiv:2010.04159,2020,[9] Junjie Huang, Guan Huang, Zheng Zhu, et al. Bevdet: High-performance multi-camera 3d object detection in bird-eye-view[J]. arXiv preprint arXiv:2112.11790,2021,[10] Yinhao Li, Zheng Ge, Guanyi Yu, et al. BEVDepth: Acquisition of Reliable Depth for Multi-View 3D Object Detection[J]. Proceedings of the AAAI Conference on Artificial Intelligence,2023,37(2): 1477-1485[11] Nicolas Carion, Francisco Massa, Gabriel Synnaeve, et al. End-to-end object detection with transformers[A].Springer: 213-229[12] Zhiqi Li, Wenhai Wang, Hongyang Li, et al. Bevformer: Learning bird’s-eye-view representation from multi-camera images via spatiotemporal transformers[A].Springer: 1-18[13] Hongyang Li, Chonghao Sima, Jifeng Dai, et al. Delving into the Devils of Bird's-eye-view Perception: A Review, Evaluation and Recipe[J]. arXiv preprint arXiv:2209.05324,2022, |

文章网友提供,仅供学习参考,版权为原作者所有,如侵犯到

你的权益请联系542334618@126.com,我们会及时处理。

会员评价:

共0条 发表评论